-

[DeepSeek-r1] Ollama로 로컬 컴퓨터에 DeepSeek 쉽게 설치하기Data & ML & AI/LLM 2025. 2. 1. 04:00반응형

미국 주식시장이 출렁일 정도로 DeepSeek에 대한 충격이 큽니다.

바로 설치해봅시다.

전반적인 설치, LlamaIndex를 사용한 추가 활용법은 이전 포스트와 전반적으로 일치합니다.

[Llama3] Ollama와 Llama-Index로 Llama3 쉽게 시작하기(ubuntu)

1. 사전 세팅1) Ollama 준비# ollama 설치curl -fsSL https://ollama.com/install.sh | sh# ollama app 실행ollama serve# 정상 작동여부 확인 (새 터미널에서)ollama run llama3모델을 처음 돌릴 때는 해당 모델 설치를 진행합

brain-nim.tistory.com

이 글에서는 Ollama 설치부터 DeepSeek 설치까지는 그대로 진행하되 LlamaIndex나 LangChain 활용은 생략하고

간단히 마무리 지어볼까 합니다.

1. Ollama 설치

1) 윈도우에 설치하는 경우

Ollama 공식 링크 들어가면 바로 다운로드 버튼이 보입니다.

그대로 설치합니다.

커엽 # CMD나 Powershell에서 정상설치 확인 ollama -v2) Linux 등에 설치하거나 WSL을 활용할 경우

# ollama 설치 curl -fsSL https://ollama.com/install.sh | sh # ollama app 실행 ollama serve

정상작동중입니다. 2. DeepSeek 모델 선택

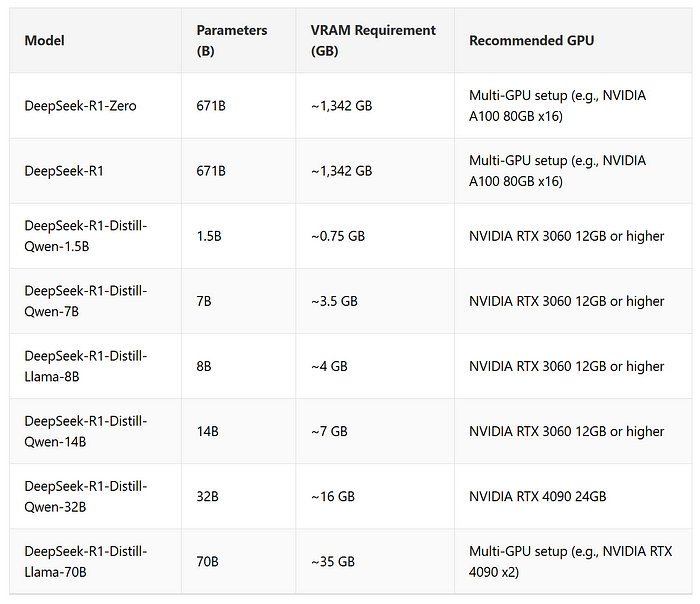

1) 선택기준1: VRAM

자신의 GPU RAM 크기를 고려해봅시다

제 VRAM 크기는 6GB이하이므로 7B아님 8B를 선택해야겠습니다. 2) 선택기준2: 성능

단순히 크기가 크다고 좋은건 아닙니다.

DeepSeek-R1은 Qwen 기반으로도 만들고 Llama 기반으로도 만들었는데,

아래의 표를 보면 7B의 성능이 8B의 성능보다 좋고, 32B와 70B의 성능이 많이 유사함을 알 수 있습니다.

그렇다면 8B대신 7B를, 70B 대신 32B를 선택하는게 더 유리할 가능성이 있습니다.

그와중에 Claude와 GPT를 압도하네요ㄷㄷㄷ

어쨋든 전 7B를 선택하겠습니다. 3. DeepSeek 모델 설치

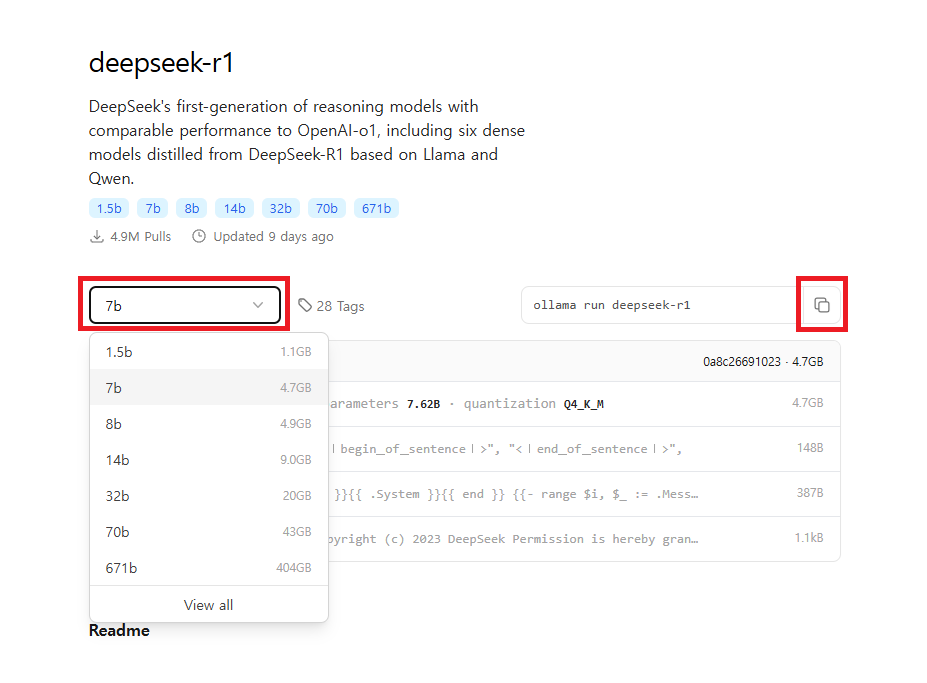

1) Ollama deepseek-r1 링크로 접속

2) 원하는 모델 선택 후 명령어 복사

전 7b를 선택했습니다. 3) deepseek 모델 실행

# ollama run {위에서 복사한 명령어의 모델명} ollama run deepseek-r1반응형'Data & ML & AI > LLM' 카테고리의 다른 글

[LlamaIndex] Llama-Index와 DB 연동하기(DatabaseReader, feat. agent) (3) 2024.10.08 [Ollama] 모델 저장위치 변경하기 (0) 2024.07.26 [Llama3] Ollama와 Llama-Index로 Llama3 쉽게 시작하기(ubuntu) (0) 2024.06.29 ChatGPT API로 서비스 구축하기 #3-2. Evaluate Inputs: Moderation (프롬프트 주입 방지하기) (2) 2023.11.28 ChatGPT API로 서비스 구축하기 #3-1. Evaluate Inputs: Moderation (윤리성 검토하기) (0) 2023.11.26